| 发布日期:2024/12/3 15:15:51 | 浏览量:497 |

第二届电力电子科普征文大赛-入围奖

上海科技大学 诸葛英健

据《华尔街日报》7月1日报道,亚马逊云服务正与美国最大的核电厂运营商Constellation Energy接近达成一项直接供电协议。而早在今年3月,亚马逊以6.5亿美元收购了位于宾夕法尼亚州的Talen Energy旗下的Cumulus数据中心园区,其由相邻的2.5GW Susquehanna核电站直接供电。

图1. Cumulus数据中心园区

近年来生成式AI掀起热潮,自ChatGPT横空出世,国内外的各种大模型和产品以令人眼花缭乱的速度更新迭代。在ChatGPT不断发展的同时,微软紧随其后,将云服务全线铺开,并将Copilot深度集成到Windows生态中。Google也推出了Bard,并在之后推出了原生多模态大模型Gemini。国内市场,2023年3月,百度正式发布预训练生成式大语言模型“文心一言”。此后,讯飞“星火”、阿里云“通义千问”、腾讯“混元”、华为“盘古”等大模型陆续发布。用户不仅可以与人工智能进行实时对话,还可以让AI协助自己进行资料检索、概括总结等工作,甚至帮自己写代码以及修改论文。

很快地,大模型扩展到了文本应用以外的领域。以Stable Diffusion、Midjourney|、Adobe Firefly等为代表,文生图领域同样突飞猛进。文本生成视频领域同样在快速进化,Sora、Pika、Luma、快手可灵AI等竞争激烈,近几日全面开放的Runway3,更是已经可以生成10s的视频。

随着人工智能的飞速发展,其耗电量也在急剧上升,甚至大量科技公司都在与核电站所有者进行洽谈,那么能源会成为限制其发展的绊脚石吗?

一、AI为什么耗电

思考是消耗热量的,仅占人体2%重量的大脑却消耗了人体约20%的能量。类似地,人工智能也是很耗能的。根据国际能源署估计,在2022年,数据中心、加密货币、人工智能(AI)消耗了大约460 TWh的电力,几乎占全球总电力需求的2%,而这一数据,预计到2026年将超过1000 TWh [1]。

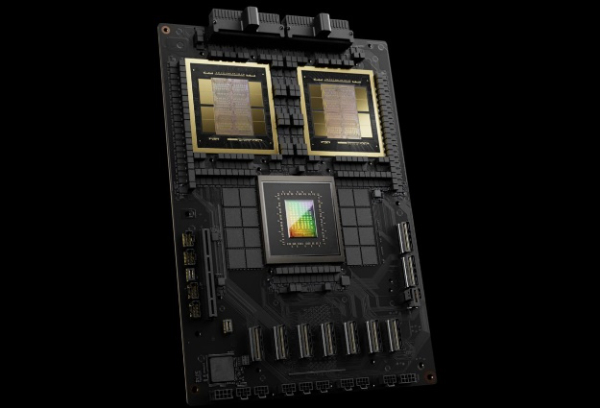

早在2022年,Hugging Face的研究者们就量化了各个大模型的耗电量和碳排放数据。其自家的BLOOM,拥有1760亿参数的大模型,前期训练时长约118天,就花掉了43.3万度电。而参数量与之相当的GPT-3,更是耗电128.7万度,与121个美国家庭一整年的平均耗电量相当[2]。GPT-3训练用到了1024张A100芯片,被称为“千卡千参”,而目前的GPT-4、GPT-5等大模型都达到了“万卡万参”的规模,同时所用芯片也从A100更新到了H100、B200,参数量的激增导致能耗显著增加。有人估算,GPT-4的一次训练中仅GPU就耗电2.4亿度。

图2. Technology advancement | @ TSMC

图3. GB200-Superchip | @ NVIDIA

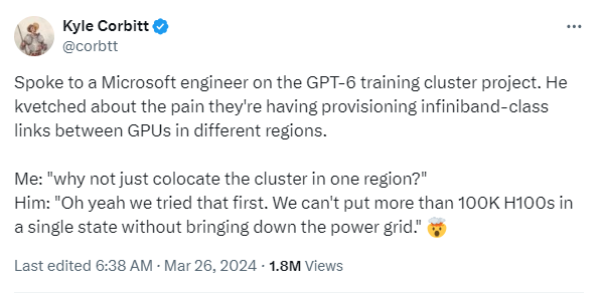

另一方面,大模型的训练过程甚至会导致局部电网的崩溃。Kyle Corbitt在今年3月曾发表消息称,训练GPT-6的微软工程师们正在搭建Infiniband网络,把不同地区的GPU连接起来,如果将这10万块H100芯片部署在同一地区,电网则会崩溃。

图4. tweets内容 | @ X @corbtt

但人工智能的高能耗不仅仅体现在前期训练过程中,更是在后期使用过程中的累积。

前期的训练过程就是反复调整模型参数,直到模型的性能不再显著提高为止,这一阶段是有限度的。而推理阶段则大大不同,我们每向大模型问一次问题,都是一次推理请求。

图5. ChatGPT | @ OpenAI

我们每一次在搜索栏键入内容。或者点开新视频等操作,终端设备都会与某个数据中心发生信息交换,而这一些操作都需要消耗能量。Alphabet董事长John Hennessy在2023年2月指出,一次标准的Google搜索平均耗电0.3 Wh,而如果采用大模型的话,平均每次搜索的能耗将提高近10倍,即3 Wh每次。此外,根据SemiAnalysis机构的预测,谷歌要实现搜索全面人工智能化,需要512821个英伟达A100 HGX服务器,共4102568块GPU。以每个服务器6.5 kW的功率来计算,这些服务器每天的耗电量就将高达80 GWh,年耗电量29.2 TWh。根据谷歌报道,从2019年至2021年,其60%的AI相关能耗都来自推理[3]。

长远来看,AI推理过程的耗能将越来越大;短期内,AI训练的能耗是能耗的主要增量。

二、AI还是个耗水狂魔

根据兰道尔原理,处理信息是有能量成本的。但这一部分只是AI耗电中的一小部分,更多的能量消耗来自焦耳定律。

当芯片在进行信息处理时,其中的晶体管会在开关状态中进行切换,而这就产生了电流。又由于电路中电阻的存在,这些能量不可避免地转化成热能。目前台积电等芯片巨头已经在积极推进2nm工艺节点,在每平方毫米的面积上,植入3亿颗晶体管。即使单个晶体管产生的热量微乎其微,但在这么大的体量下,热量还是不容忽视的。以英伟达最新的B200芯片为例,其内含超过2080亿个晶体管,可想而知热量一定相当可观。

要进行散热,早些年利用空调冷却系统来降温,但这因为太费电而逐渐淘汰,转为利用水。

根据美国加州大学河滨分校的一项研究发现,ChatGPT等大模型的用水量令人吃惊。仅仅是训练GPT-3,15天就用掉了70万升水,更别说GPT-4等参数更多的大模型了。而在后续的使用中,据估计,每交流10-50个问题,就需要500ml水来降温。根据谷歌2024年环境报告,2023年谷歌总用水量为64亿加仑,同比增长了14%,其中数据中心用水用水量61亿加仑,同比增加17%[5]。61亿加仑,换算过来大约2379万立方米,足足可以装满一个半西湖。

除了运营维护过程中耗水,在生产芯片阶段,也需要消耗大量的水资源。制造芯片需要在晶圆上烧刻电路,而这一过程中需要大量的超纯水进行冲洗。据悉,制造8英寸晶圆每小时耗水250立方米,12英寸晶圆耗水则达到500立方米,也就是说,平均生产一个2克重的计算机芯片,就需要32公斤的水资源。根据报道,台积电2nm晶圆代工厂每日用水量预计约为4.3万吨。

根据预测,到2027年,全球人工智能需求可能会产生42-66亿立方米的取水量,这相当于丹麦每年取水总量的4-6倍。

耗水问题也制约着人工智能的飞速发展。尽管业界已经采取了许多措施来应对这些挑战,包括提高水资源利用率、推广水资源循环利用技术、加强废水处理、利用再生水等。另一方面,利用天然冷水资源为数据中心降温,例如阿里云千岛湖数据中心、微软北方群岛数据中心等,但这依然面临着严峻的挑战。

图6. 数据中心机房

三、能耗优化新动态

在解决AI能耗的问题上,业内已经使出了浑身解数。

第一个办法就是开源。

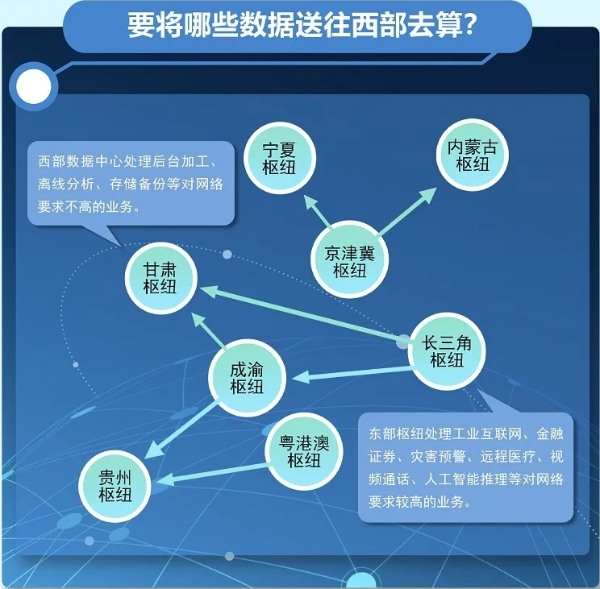

利用风能、光伏等可再生能源,以及核能,作为数据中心的运行能量。早在2021年,OpenAI CEO Sam Altman就投资了核聚变初创公司Helion Energy。2023年,亚马逊总购电量8.8GW,其中超60%的交易为购买光伏发电,其余为购买风电。亚马逊表示,其目前90%的电力都来自可再生能源,并在2025年将比例提升至100%。而开源这一办法与我国之前提出的“东数西算”工程相契合,引导数据中心向西部资源丰富地区聚集。

图7. 东数西算八大枢纽 | @ 国际科技创新中心

第二个办法就是节流。

节流一方面要从AI本身去降低能耗。剪枝(pruning)、量化(quantization)、蒸馏(distillation)等技术有望带来更好的算法,让 AI 模型更快、更节能。通过优化大模型架构,优化模型参数,从而降低训练及使用的能耗。例如,微软在4月发布的Phi-3小语言模型,其中Phi-3 small仅仅使用70亿个参数,在性能表现上就优于GPT3.5-T等大模型。在硬件层面,通过设计更加高效的芯片,例如AI模型训练专用芯片、专用推理芯片等,可以大大提升效率以及降低能耗。例如,英伟达最新集成了Blackwell芯片的GB200 NVL72,相较之前提出的Hopper,推理能力提升了30倍,训练能力提升4倍,能源使用效率提升25倍。

图8. GB200 NVL72 | @ NVIDIA

节流的另一方面就是降低冷却能耗和能量回收。华为芜湖数据中心利用直通风、液冷和云软件智能调节,将液冷机房年均PUE降至1.1,远高于行业水平,每100万台服务器每年可节省约10亿度电。除了利用自然冷却、液冷等技术降低数据中心能耗以外,利用余热回收技术进行跨季节储热,可以在供暖期间将储存的热量供给需求侧,如腾讯天津数据中心、阿里巴巴千岛湖数据中心、Facebook丹麦数据中心等。

除此以外,政策层面也需要一定程度的监管。截至2023年,美国AI相关的监管机构已经增加到了21个,并颁布了相关法规[5]。2024年3月,欧盟通过了世界上第一个全面的人工智能法律框架——《人工智能法案》。法案要求AI企业进行一定的信息披露,并致力于更高效、可持续的大模型开发。2023年4月11日,国家网信办发布了《生成式人工智能服务管理办法(征求意见稿)》,对生成式人工智能发展和规范应用提出了一系列要求。除此以外,北京及内蒙古等地都发布文件,限制数据中心冷却使用地下水、引导利用再生水等。

四、结语

人工智能正在引领一场科技革命,带给世界深远影响和巨大潜力。而人工智能的飞速发展,我们也面临着前所未有的挑战。在人工智能重塑世界的同时,我们也应该关注能源领域的进展,也许聚变的科技点就在AI之后。

参考资料:

[1] “Electricity 2024 – Analysis and forecast to 2026”. International Energy Agency, Jan. 2024.

[2] Luccioni, Alexandra Sasha, Sylvain Viguier, and Anne-Laure Ligozat. "Estimating the carbon footprint of bloom, a 176b parameter language model." Journal of Machine Learning Research 24.253 (2023): 1-15.

[3] de Vries, Alex. "The growing energy footprint of artificial intelligence." Joule 7.10 (2023): 2191-2194.

[4] “Google Environmental Report 2024”, Google, Jul. 2024.

[5] “The AI Index 2024 Annual Report,” AI Index Steering Committee, Institute for Human-Centered AI, Stanford University, Stanford, CA, April 2024.